P

paysen

Erfahrenes Mitglied

- 282

@avfreak Nee, nicht nur das. Bei vielen Geräten - Oneplus zum Beispiel - schaltet er das Postprocessing zu großen Teilen ab. Dadurch hast du dann z.B. keine künstlichen Gemälde mehr im Gras, sondern softe aber echte Details.

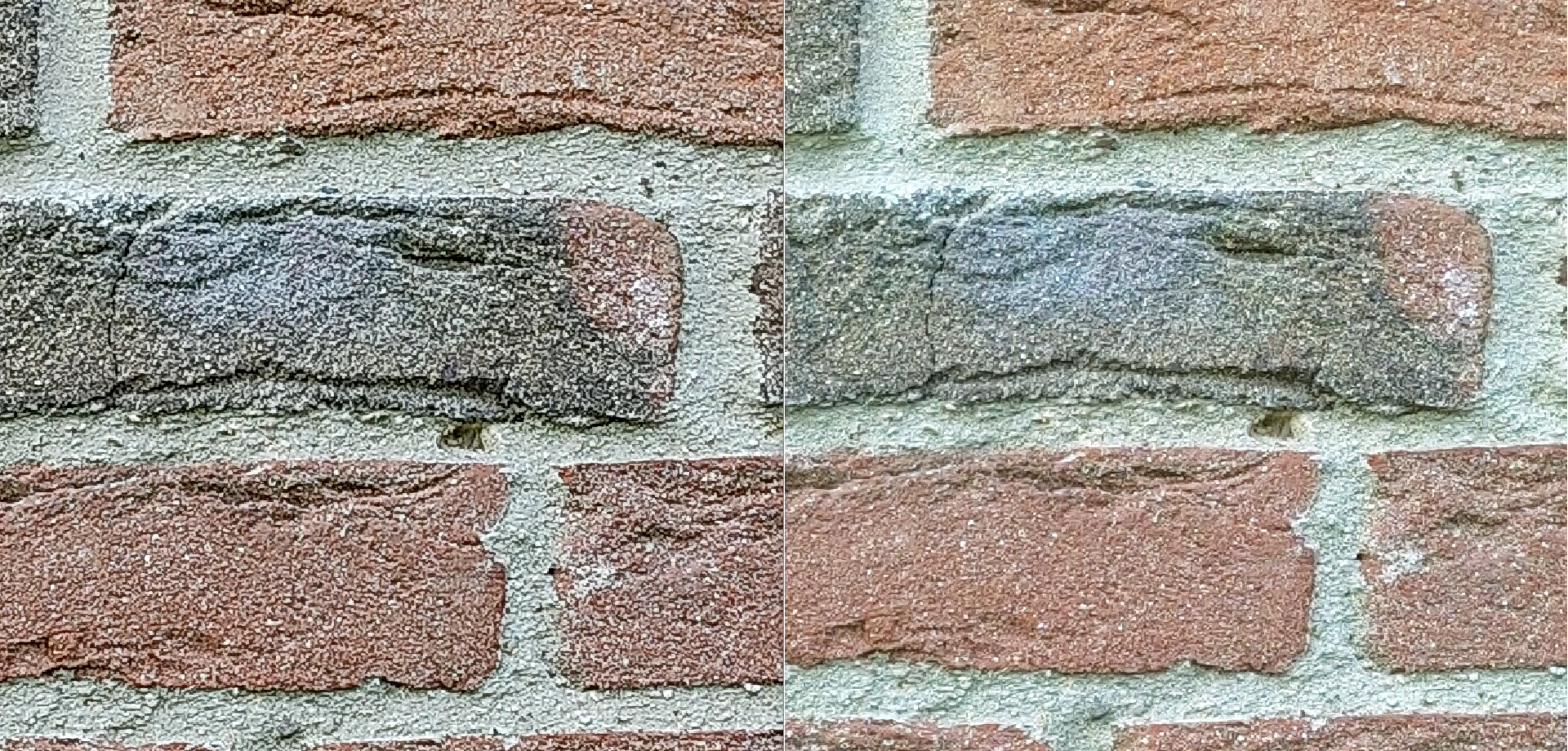

Warnung: Das ist nicht vom Mi11U, das dient nur zur Veranschaulichung. Beides 12mp. Links JPG mit Processing, rechts RAW JPG. Gibt auch deutlich bessere Beispiele, aber das soll reichen

Warnung: Das ist nicht vom Mi11U, das dient nur zur Veranschaulichung. Beides 12mp. Links JPG mit Processing, rechts RAW JPG. Gibt auch deutlich bessere Beispiele, aber das soll reichen

, wahrscheinlich hab ich dann ein GN2 Ersatzimitat)

, wahrscheinlich hab ich dann ein GN2 Ersatzimitat)

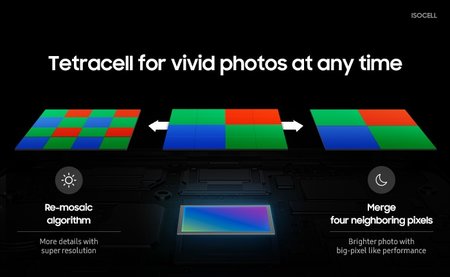

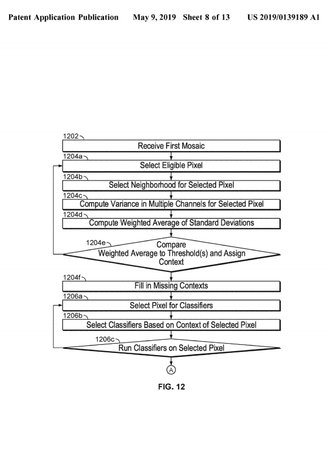

Die Binning-Sensoren sind bei Smartphones auf das Binning optimiert. Dein Ablaufdiagramm dürfte übrigens im C-Mos ablaufen.

Die Binning-Sensoren sind bei Smartphones auf das Binning optimiert. Dein Ablaufdiagramm dürfte übrigens im C-Mos ablaufen.