merlin2100

Enthusiast

- 5.534

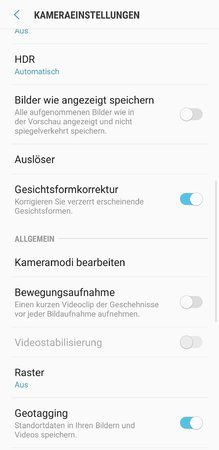

Ich habe eben mal bei meinem S9 in den Kameraeinstellungen geschaut, ob es dort einen Menüpunkt mit Gesicht oder so etwas gibt und bin auch prompt fündig geworden.

Es gibt einen Punkt "Gesichtsformkorrektur". Ich habe keine Ahnung was diese bewirkt oder funktioniert, aber vielleicht ändert sich ja etwas, wenn man diesen ausschaltet.

Nebenbei, war dieser von Anfang an vorhanden? Ich bin mir nicht so ganz sicher.

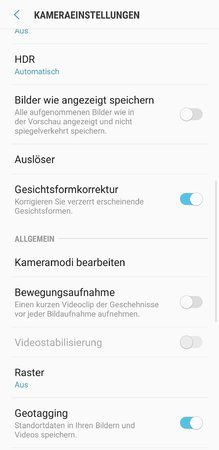

Es gibt einen Punkt "Gesichtsformkorrektur". Ich habe keine Ahnung was diese bewirkt oder funktioniert, aber vielleicht ändert sich ja etwas, wenn man diesen ausschaltet.

Nebenbei, war dieser von Anfang an vorhanden? Ich bin mir nicht so ganz sicher.